A CNPD decidiu, a 26 de março, suspender a recolha de dados biométricos faciais e da íris que a empresa Worldcoin recolhe há vários meses. A decisão surge na sequência de uma avalanche de denúncias recebidas pela CNPD, denunciando a recolha de dados biométricos de menores sem autorização dos pais ou representantes legais, bem como deficiências na informação prestada para a recolha desses dados, e na sequência de uma recomendação de prudência da própria CNPD aos cidadãos relativamente ao fornecimento desses dados, encorajando “as pessoas a refletirem sobre a sensibilidade dos dados que pretendem fornecer, que são únicos e fazem parte da sua identidade, e os riscos que tal implica, e a ponderarem o significado de a cedência dos seus dados biométricos envolver, em contraprestação, um eventual pagamento”. É preciso ainda ter em conta que, em troca dos dados, a empresa entregou criptomoedas cuja existência tem sido reportada como duvidosa (já para não falar da sua elevadíssima volatilidade em geral).

Em Espanha, no início de março, a AEPD ordenou a suspensão cautelar da atividade da Worldcoin pelos mesmos motivos que a CNPD hoje apresenta. A medida foi objeto de recurso pela Worldcoin. Porém, a Audiencia Nacional considerou que a atuação da AEPD foi correta, porque a salvaguarda do interesse geral, que consiste na garantia do direito à proteção dos dados pessoais dos seus titulares, deve prevalecer sobre o interesse particular da empresa recorrente, de conteúdo fundamentalmente económico. A Audiencia Nacional argumenta que, se se verificasse que a Worldcoin cumpre o RGPD, poderia solicitar uma compensação financeira baseada na medida cautelar, estando reunidos os respetivos requisitos. Não parece muito provável, uma vez que a medida cumpre os três requisitos fundamentais: fumus boni iuris, periculum in mora e proporcionalidade.

O caso, como se pode ver, deu origem a um intenso debate em Espanha e em Portugal, bem como noutros países da União Europeia. A conduta da empresa é duvidosa – e não só devido às deficiências na informação contratual fornecida ou às características da contraprestação oferecida. São também utilizadas práticas questionáveis nos stands de informação e venda da Worldcoin para convencer as pessoas (muitas delas menores de idade) a vender os seus dados biométricos.

Há, no entanto, outro aspeto que importa analisar. Estamos a falar da natureza intra commercium dos dados pessoais.

Há alguns meses, neste blog, discuti os requisitos do pagamento com dados, partindo do princípio de que esta realidade é legalmente possível, e até aconselhável, apesar das reticências expressas na altura pelo EDPS e pelo EDPB, recentemente atualizadas em relação ao debate em torno do modelo “pay or ok”. Isto implica também que a lei deve encarar os dados pessoais não só como parte de um direito fundamental (art. 8.º da Carta Europeia de Direitos Fundamentais; art. 18.º, n.º 4, da Constituição Espanhola; art. 26.º da Constituição Portuguesa), mas também como um ativo económico, ou seja, como bens num sentido patrimonial, que podem ser transacionados e, por conseguinte, utilizados como contraprestação. Se os dados podem constituir uma contraprestação, devem também poder ser uma prestação principal. Por outras palavras, se uma pessoa pode pagar certos bens e serviços digitais com os seus dados pessoais, nada deve impedi-la, pela mesma razão, mas em sentido inverso, de entregar os seus dados pessoais em troca de pagamento (seja em moeda com curso legal, criptomoeda ou qualquer outro tipo de contraprestação).

De acordo com esta lógica, não deveria haver qualquer impedimento à comercialização de dados pessoais, apesar de o direito à proteção de dados ser um direito fundamental; tal como o direito à vida privada e familiar (art. 7.º da Carta Europeia de Direitos Fundamentais; art. 18.º, n.º 1, da Constituição Espanhola; art. 26.º da Constituição Portuguesa), o que não impede que sejam objeto de comercialização através da venda de direitos de imagem a marcas comerciais, da venda de exclusivos de pessoas conhecidas, ou da própria atividade de alguns influencers e youtubers, que claramente comercializam tanto a sua imagem como a sua privacidade.

O caso Worldcoin sugere uma reflexão mais aprofundada sobre o carácter intra commercium dos dados pessoais: será que todos os dados pessoais devem ser comercializáveis e, portanto, servir de contraprestação para o pagamento de certos bens e serviços digitais (ou vice-versa)?

Uma primeira resposta a esta questão pode ser afirmativa: todos os dados pessoais devem ser comercializáveis porque o direito fundamental à proteção de dados pode ser comercializável na mesma medida que outros direitos fundamentais que lhe são próximos, como o direito à privacidade pessoal ou familiar ou o direito à própria imagem. A comercialidade do direito à própria imagem não difere em função do conteúdo da imagem pessoal que é objeto de comércio: é tão comercial posar para uma marca como ser filmado nu para um filme. Será diferente a questão das regras específicas aplicáveis a cada atividade, além da comercialização do direito à própria imagem. Pensemos, por exemplo, na atuação de menores em filmes.

A segunda resposta que pode ser dada é não. Esta resposta, formulada em termos absolutos, já foi partilhada pelo EDPS e pelo EDPB, e já foi respondida em várias ocasiões, em relação à desproporcionalidade da posição e do argumento. Resta, portanto, optar por uma resposta à moda galega: depende. Segundo esta opção (a nosso ver mais precisa e proporcionada), os dados pessoais não devem ser considerados comercializáveis ou não pelo simples facto de serem dados pessoais, mas em função do tipo de informação a que se referem. Deve estabelecer-se uma presunção geral iuris tantum de comercialidade e prever-se restritivamente as categorias de dados pessoais que devem ser excluídas do comércio. Uma primeira tentativa de situar este “depende” seria a grande divisão traçada pelo RGPD entre dados pessoais comuns e categorias especiais de dados pessoais. É claro que os dados pessoais “comuns” seriam totalmente comercializáveis.

O RGPD define dados pessoais como “qualquer informação relativa a uma pessoa identificada ou identificável” (art. 4.1) e distingue duas grandes categorias de dados pessoais: dados pessoais comuns e categorias especiais de dados pessoais. Os dados pessoais comuns são definidos por exclusão: todos os dados que não são considerados categorias especiais de dados pessoais. As categorias especiais de dados pessoais são os dados que revelam a origem racial ou étnica, as opiniões políticas, as convicções religiosas ou filosóficas ou a filiação sindical; e os dados genéticos, os dados biométricos, os dados relativos à saúde, à vida sexual e à orientação sexual de uma pessoa singular (art. 9.1 RGPD).

As categorias especiais de dados pessoais representam um risco mais elevado para os direitos e liberdades fundamentais (Cons. 51 RGPD), razão pela qual o art. 9.1 RGPD prevê uma proibição geral de tratamento destas categorias de dados. Na prática, este sistema bipartido implica o seguinte: (1) em princípio, todo o tratamento de dados deve ser efetuado de acordo com uma base legítima, tal como estabelecido no art. 6 RGPD. No caso de categorias especiais de dados, não só deve ser selecionado pelo menos um fundamento de legitimação do art. 6 RGPD, como também deve ser encontrada uma exceção à proibição geral de tratamento de categorias especiais de dados (art. 9.1 e 9.2 RGPD).

Embora seja verdade que, em geral, o tratamento de categorias especiais de dados implica um risco maior para os direitos e liberdades das pessoas em causa, nem todos eles devem ser excluídos do comércio, mas apenas aqueles cujo tratamento não está sujeito a um controlo ou regulamento específico e que, por si só, implica um risco ainda maior para os direitos e liberdades não só das pessoas em causa, mas da população em geral. Recordemos que partimos da presunção iuris tantum de que os dados pessoais são bens intra commercium e que, por conseguinte, a exclusão do comércio de certas categorias de dados deve encontrar uma razão justificada que permita destruir a presunção e que mesmo essa razão deve ser interpretada de forma restritiva.

Que dados pessoais devem então ser excluídos do comércio?

Entendemos que a exclusão deve estender-se principalmente a três categorias de dados pessoais, tal como definidas no RGPD: (1) dados genéticos, (2) dados biométricos e (3) dados relativos à saúde:

– Os dados genéticos são “dados pessoais relativos às características genéticas herdadas ou adquiridas de uma pessoa singular que fornecem informações únicas sobre a fisiologia ou a saúde dessa pessoa, obtidas, nomeadamente, a partir da análise de uma amostra biológica dessa pessoa” (art. 4.13 RGPD);

– Os dados biométricos são “dados pessoais obtidos a partir de um tratamento técnico específico, relativos às características físicas, fisiológicas ou comportamentais de uma pessoa singular, que permitem ou confirmam a identificação única dessa pessoa, tais como imagens faciais ou dados dactiloscópicos” (art. 4.14 RGPD);

– E os dados relativos à saúde são “dados pessoais relativos à saúde física ou mental de uma pessoa singular, incluindo a prestação de serviços de saúde, que revelem informações sobre o seu estado de saúde” (art. 4.15 RGPD).

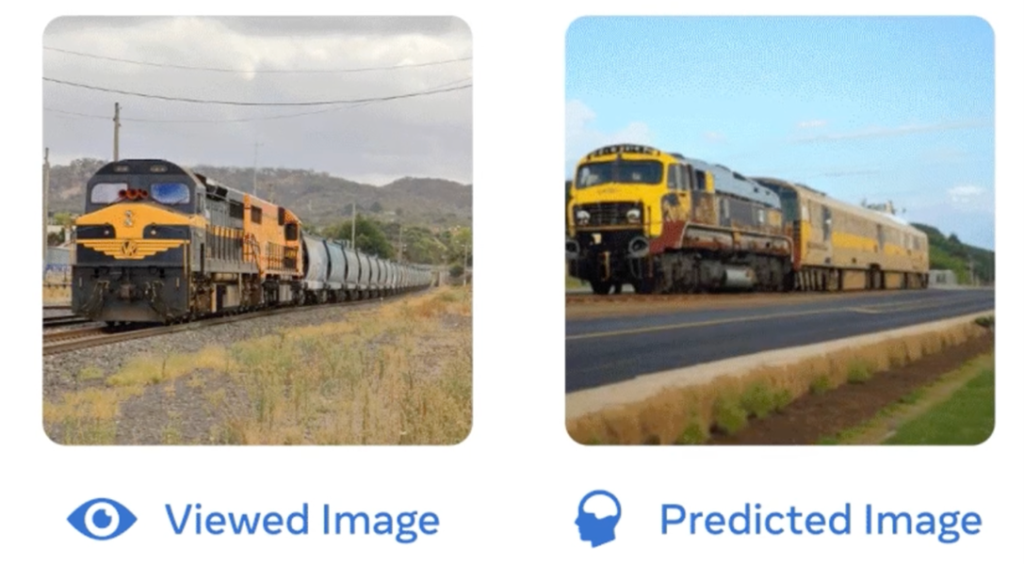

As interfaces cérebro-computador (ICC) permitem medir e registar a atividade gerada pelo cérebro, que servirá de identificador biométrico. As ondas cerebrais registadas por uma BCI são traduzidas em dados fisiológicos depois de processadas e descodificadas. Aplicando ferramentas avançadas de análise de dados e sistemas de IA, é possível inferir pensamentos, sentimentos, estados de saúde, traçar o perfil do indivíduo e fazer inferências sobre o seu passado, presente e futuro. Por outro lado, o cérebro é um identificador único, tal como a impressão digital ou o genoma. Além disso, a neurotecnologia permite não só recolher informações neurológicas em tempo real, mas também gerar estímulos que alteram a atividade cerebral e modificam o comportamento da pessoa a curto e a longo prazo. Em última análise, esta tecnologia e a utilização de dados neurológicos apresentam sérios riscos para os direitos e liberdades fundamentais dos indivíduos. Isto levou alguns Estados, como o espanhol, a começar a propor a elaboração de direitos dos cidadãos em relação à utilização das neurotecnologias, embora, por enquanto, apenas como propostas regulamentares sujeitas a debate (Artigo XXVI Carta dos Direitos Digitais). No que nos diz respeito, os neurodados devem ser entendidos como uma subcategoria dos dados biométricos.

Os dados genéticos, os dados biométricos e os dados relativos à saúde são as únicas três categorias especiais de dados pessoais definidas no art. 4 RGPD e as únicas para as quais o RGPD permite que os Estados-Membros introduzam restrições ao tratamento, desde que não constituam um obstáculo à sua livre circulação (art. 9.4 RGPD). Estas circunstâncias demonstram a importância destas três categorias de dados pessoais, além de serem categorias especiais de dados.

O tráfico de dados genéticos, biométricos e relativos à saúde deve ser objeto de uma regulamentação específica, de modo a que a sua circulação constitua um “tráfico regulamentado”, devido à natureza especial das informações a que se referem. Esta é a razão das possíveis restrições nacionais que o RGPD permite que os Estados-Membros imponham e, sobretudo, a razão da atual construção do Espaço Europeu de Dados de Saúde (EEDS). No âmbito do EEDS, foi publicada uma Proposta de Regulamento sobre o Espaço Europeu de Dados de Saúde, relativa à utilização de dados de saúde, ou seja, dados de saúde e dados genéticos (art. 2.2, alíneas a), b) e c)). No que diz respeito aos dados biométricos, o seu impacto particular nos direitos e liberdades fundamentais refletiu-se no Regulamento relativo à Inteligência Artificial, que classifica os sistemas de identificação biométrica como de alto risco (Anexo III, nº 1, e Cons. 44 e 54).

Uma questão discutível é a de saber onde termina a fronteira dos dados biométricos ou relacionados com a saúde ou, por outras palavras, como lidar com a vis expansiva destas categorias de dados. Um exemplo desta vis expansiva é o facto de uma fotografia de uma pessoa poder ser considerada um dado biométrico se permitir a identificação unívoca ou de uma pessoa (Cons. 51 RGPD), ou o facto de, por vezes, a mera consulta de determinados sítios web também poder ser considerada um dado relativo à saúde (Cons. 68 a 73 da Sentença do TJUE, de 4 de julho de 2023).

Em suma, o princípio da livre circulação de dados pessoais protegido e promovido pelo RGPD (e anteriormente pela Diretiva 95/46/CE) deve levar ao entendimento de que o tráfego económico de dados pessoais é legal, desde que os requisitos para qualquer troca de serviços onerosos sejam cumpridos de acordo com as regras dos Estados-Membros em matéria de obrigações e contratos. Isto implica que o pagamento com dados pessoais para determinados bens e serviços deve ser entendido como possível, por exemplo, escolhendo entre o pagamento com dados de modo a permitir uma navegação personalizada com base em perfis (ver o art. 38 do Digital Services Act) ou pagamento monetário pelo mismo serviço, como recentemente recordado pelo TJUE, na Sentença de 4 de julho de 2023 (Cons. 150 em particular). Do que precede deve resultar que é igualmente lícito vender os próprios dados pessoais em troca de uma contraprestação.

No entanto, embora se deva partir do princípio de que todos os dados pessoais são comercializáveis, devem ser excluídos do comércio os dados pessoais cujo tratamento (e especialmente cujo tráfico não está sujeito a regulamentação específica) tem um maior impacto nos direitos e liberdades fundamentais. Estes dados são, a nosso ver, os dados biométricos (incluindo os neurodados), os dados genéticos e os dados relativos à saúde.

Considerar certas categorias de dados como dados fora do comércio não implica que essas categorias de dados não sejam objeto de análise, nem exclui o desenvolvimento de perfis com base nessa análise de dados. Trata-se apenas de fazer avançar a barreira da proteção, não no final da cadeia de valor dos dados (ou seja, proteção contra atividades de definição de perfis de indivíduos específicos), mas no início (recolha e tráfico livres dos dados que alimentam os perfis). A livre circulação destas categorias de dados também não seria impedida: trata-se apenas de submeter essa circulação a um controlo público no interesse de uma melhor proteção dos direitos e liberdades afetados pela informação a que estas categorias de dados se referem. Aliás, isto já está no espírito do Regulamento europeu relativo ao espaço de dados de saúde.

De acordo com isto, a atividade desenvolvida pela Worldcoin não só constituiria um tratamento de dados questionável pelas razões já invocadas por autoridades nacionais como a AEPD ou a CNPD, mas também por se tratar de um tráfego oneroso de dados pessoais extra commercium.